目录

概述

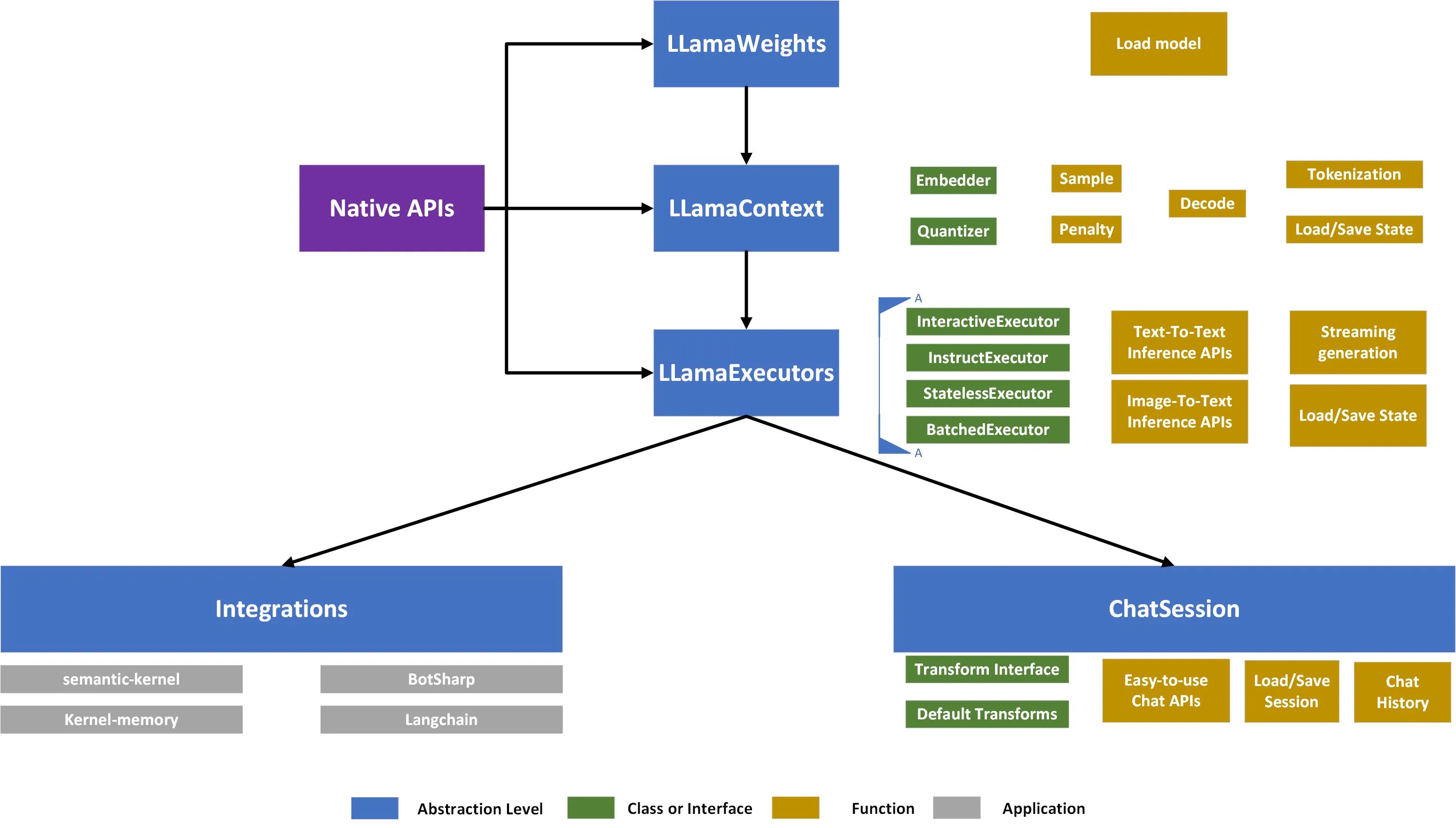

LLamaSharp 是一个跨平台的库,旨在高效地在本地设备上运行 LLaMA 和 LLaVA 模型。基于 llama.cpp 开发,LLamaSharp 提供了在 CPU 和 GPU 上进行推理的能力,支持更高级别的 API 和 RAG(检索增强生成)功能,使得在应用程序中部署大型语言模型(LLM)变得更加便捷。

官网

Markdownhttps://github.com/SciSharp/LLamaSharp

主要功能

1. 高效的 LLM 推理

LLamaSharp 的核心功能是提供一种有效的方法在用户的设备上运行 LLM 推理,并支持未来的模型微调。用户需要从其他资源(如 Hugging Face)下载模型权重。

2. 后端支持

为了实现高性能,LLamaSharp 与从 C++ 编译的本机库交互,支持 Windows、Linux 和 macOS 的 CPU、CUDA、Metal 和 OpenCL 后端。用户无需处理 C++ 相关内容,只需安装相应的后端包。

3. 模型格式支持

LLamaSharp 支持多种模型格式,包括 PyTorch 格式(.pth)和 Hugging Face 格式(.bin),并使用 GGUF 格式文件。用户可以通过以下方式获取 GGUF 格式文件:

- 在 Hugging Face 中搜索模型名称加上“gguf”。

- 按照 llama.cpp 的说明,将 PyTorch 或 Hugging Face 格式转换为 GGUF 格式。

4. 多模态支持

LLamaSharp 支持多模态输入,允许模型同时处理文本和图像。使用多模态(LLaVA)时,需要主模型和 mm-proj 模型的两个文件。

应用场景

LLamaSharp 的灵活性和高效性使其适用于多种应用场景,包括但不限于:

- 聊天机器人:利用 LLamaSharp 的交互式执行器,开发者可以创建智能聊天机器人,提供自然语言处理和对话生成能力。

- 内容生成:通过指令执行器,用户可以生成高质量的文本内容,适用于博客、文章和社交媒体帖子等。

- 图像处理:结合多模态支持,LLamaSharp 可以处理图像和文本输入,适用于图像描述生成和视觉问答等应用。

- 数据检索:通过 RAG 集成,LLamaSharp 可以在大型数据集上进行高效检索,适用于信息检索和知识问答系统。

集成与扩展

LLamaSharp 提供了多种插件和集成,扩展其应用能力,包括:

- semantic-kernel:集成 OpenAI、Azure OpenAI 和 Hugging Face 的 SDK。

- kernel-memory:用于高效索引数据集的多模态 AI 服务,支持 RAG、合成内存和自定义语义内存处理。

- BotSharp:开源机器学习框架,适用于 AI Bot 平台构建。

- Langchain:用于开发由语言模型驱动的应用程序的框架。

结论

LLamaSharp 是一个功能强大且灵活的库,适合希望在本地设备上高效运行 LLM 的开发者和研究人员。通过其丰富的功能和广泛的应用场景,LLamaSharp 为用户提供了一个理想的平台来探索和实现各种 AI 应用。

本文作者:技术老小子

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!