背景介绍

Semantic Kernel 是微软推出的一个强大框架,允许开发者轻松创建具有高级功能的AI代理。本文将详细指导你如何使用C#创建一个交互式AI应用。

准备工作

安装必要的NuGet包

首先,你需要安装以下NuGet包:

Bashdotnet add package Microsoft.SemanticKernel dotnet add package Microsoft.Extensions.Logging dotnet add package Microsoft.Extensions.Logging.Console

配置服务

在开始之前,确保你已经:

- 我这用的是siliconflow,你也可以用第三方的,默认是OpenAI或Azure

- 获取了模型部署ID

- 准备好API密钥和终端点

代码实现

完整的控制台应用程序示例

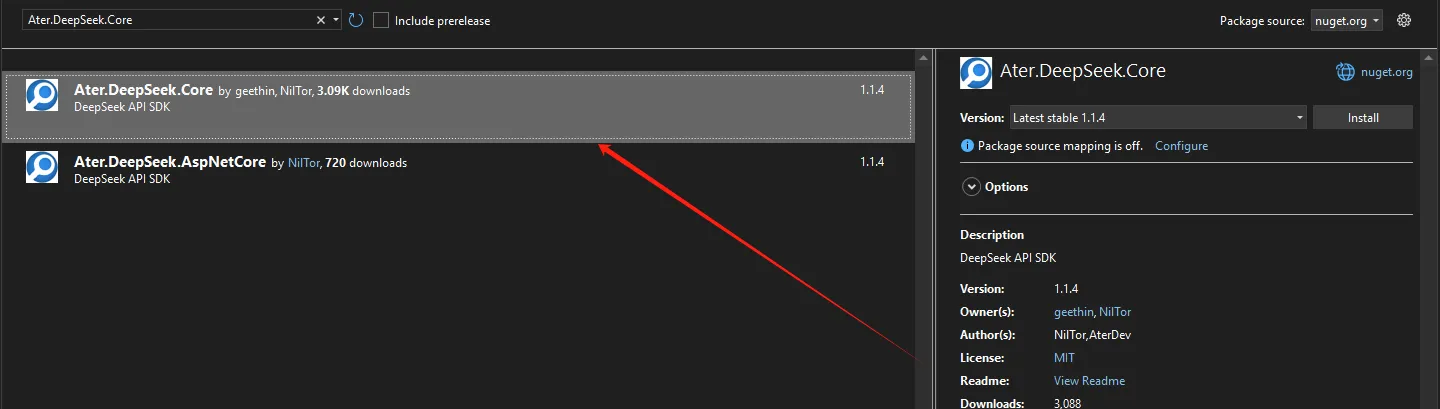

DeepSeek 提供了强大的 API 接口,特别适合 .NET 开发者。本文将详细介绍如何在 C# 中使用 DeepSeek SDK,包括安装、配置和示例代码,帮助你快速上手,说白了就是httpclient打了个包。

🚀 DeepSeek SDK 特性

- 模型列表:获取可用模型的列表

- 聊天与聊天流:支持实时聊天功能

- 补全与补全流:生成文本补全(测试版)

- 用户余额:查询用户的 API 使用余额

- 本地模型支持:支持本地模型调用

- ASP.NET** Core 集成**:轻松集成到 ASP.NET Core 应用中

📦 安装 DeepSeek SDK

首先,你需要在 DeepSeek 官方网站 注册并申请 API Key。确保你的 .NET 版本为 .NET 8。

安装 NuGet 包

在你的项目中,使用以下命令安装 DeepSeek SDK:

Bashdotnet add package Ater.DeepSeek.Core

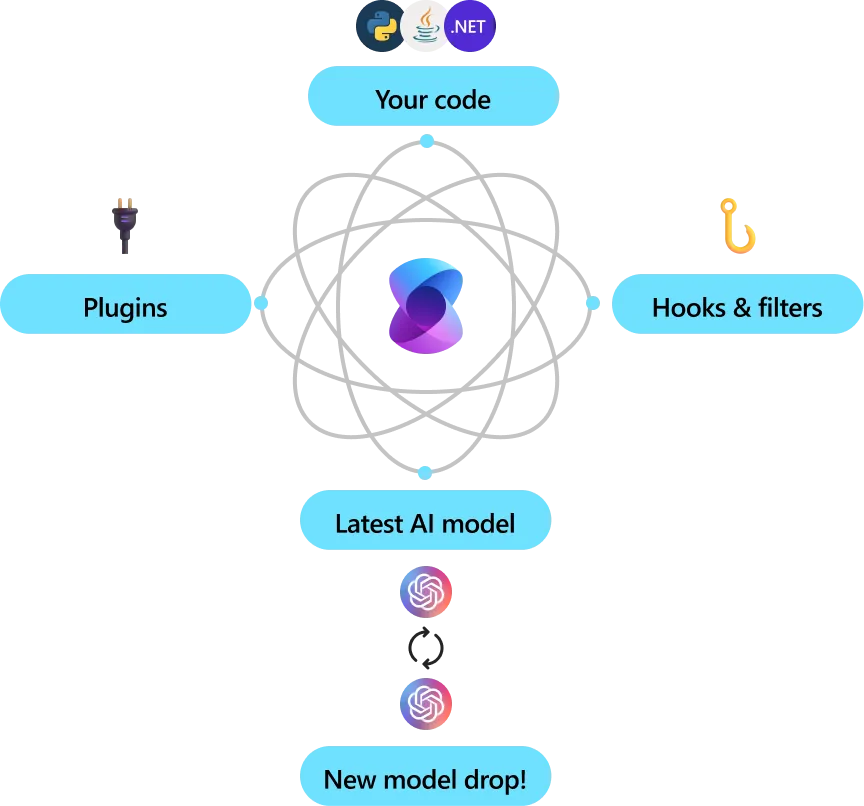

在当今技术快速发展的环境下,企业需要灵活高效的工具来集成最新的人工智能(AI)模型。语义内核(Semantic Kernel)是一个轻量级的开源开发工具包,专注于帮助开发者轻松构建AI代理,并将最新的AI模型整合到C#、Python或Java代码库中。本文将深入探讨语义内核的特点与优势,同时介绍如何开始使用这一工具。

企业级解决方案

灵活性与可扩展性

语义内核已经被微软及其他财富500强公司广泛采用,原因在于其灵活性、模块化和可观察性。该工具包提供了增强安全性的功能,如遥测支持、钩子和过滤器,使开发者能够自信地交付负责任的AI解决方案。语义内核支持C#、Python和Java的版本1.0+,确保了其可靠性,并承诺不会出现破坏性更改。

Microsoft.Extensions.AI 是一个强大的 .NET AI 集成库,专注于为开发者提供丰富的功能,以便在 .NET 应用程序中轻松实现 AI 功能的集成。通过该库,用户可以方便地扩展和增强应用程序的智能化能力。本指南将深入介绍其主要特性及具体的使用方法,帮助开发者快速上手并充分利用 Ollama 提供的强大工具集。

先决条件

在开始之前,请确保满足以下条件:

- 安装 .NET 8 SDK

- 安装 Visual Studio 或 VS Code

- 安装 Ollama

Nuget 安装包

PowerShellNuGet\Install-Package [Microsoft.Extensions.AI](http://Microsoft.Extensions.AI) -Version 9.3.0-preview.1.25114.11 NuGet\Install-Package Microsoft.Extensions.AI.Ollama -Version 9.3.0-preview.1.25114.11

OllamaSharp 是一个强大的库,为 Ollama API 提供 .NET 绑定,使得与 Ollama 的本地和远程交互变得更加简单。本文将指导您了解 OllamaSharp 的功能、设置和使用方法,并提供详细的示例和解释。

OllamaSharp 的特点

- 易于使用:只需几行代码即可与 Ollama 进行交互。

- 可靠性:支持 Microsoft Semantic Kernel、.NET Aspire 和 Microsoft.Extensions.AI 等多个 Microsoft 项目。

- API 覆盖:覆盖所有 Ollama API 端点,包括聊天、嵌入、列出模型、拉取和创建新模型等。

- 实时流式传输:直接将响应流式传输到您的应用程序。

- 进度报告:对拉取模型等任务提供实时进度反馈。

- 工具引擎:支持 复杂的工具和源生成器。

- 多模态:支持 视觉模型,扩展应用程序的能力。

官网

Markdownhttps://github.com/awaescher/OllamaSharp